Mehr Daten, aber nicht mehr Klarheit: Warum moderne Streitkräfte und Behörden trotz wachsender Datenmengen ihre Entscheidungszyklen oft nicht verkürzen können – und wie Datenverarbeitung zur eigenständigen operativen Fähigkeit wird. Darüber lesen Sie in unserem heutigen externen Fachartikel.

Moderne Streitkräfte, Behörden und Defence-Unternehmen erzeugen heute mehr Daten als jemals zuvor. Sensorik, Simulation, Logistik, Cyber-Monitoring und Betriebssysteme liefern kontinuierlich große Datenmengen in hoher Granularität. Gleichzeitig zeigt sich jedoch ein paradoxes Bild: Trotz wachsender Datenverfügbarkeit verkürzen sich Entscheidungszyklen häufig nicht im gleichen Maße.

Diese Diskrepanz ist kein Einzelfall und kein Organisationsversagen. Sie verweist auf ein strukturelles Problem: Die Fähigkeit, Daten zeitnah in handlungsrelevante Erkenntnisse zu überführen, hält mit der wachsenden System- und Datenkomplexität nicht Schritt.

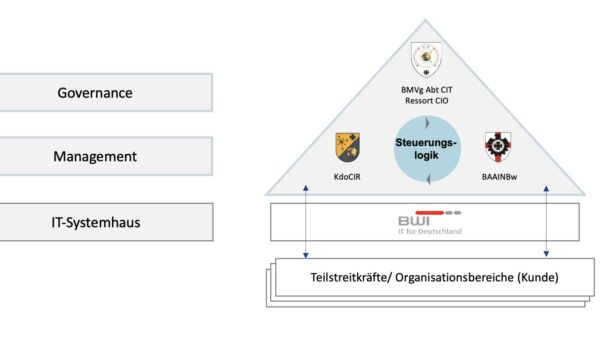

Internationale Studien – darunter die EU Defence Industry Transformation Roadmap (2024) und das NATO DIANA-Programm (Data-Assisted Decision Making) – unterstreichen einen paradigmatischen Wandel im Defence-Sektor: Datenverarbeitung ist nicht länger eine unterstützende IT-Funktion, sondern entwickelt sich zur eigenständigen operativen Fähigkeit, vergleichbar mit Sensorik oder Kommunikationssystemen.

Entscheidungsgeschwindigkeit als operativer Wirkfaktor

In sicherheits- und verteidigungsrelevanten Kontexten ist Zeit seit jeher ein kritischer Faktor. Neu ist jedoch, dass Entscheidungsqualität und -geschwindigkeit zunehmend von der Leistungsfähigkeit datenanalytischer Prozesse abhängen.

Lagebilder, Einsatzvorbereitung, Instandhaltungsplanung oder Cyber-Reaktion basieren heute nicht mehr auf einzelnen Informationsquellen, sondern auf der Korrelation großer, heterogener Datenbestände – von Radardaten über EO/IR (Electro-Optical/Infra-Red), elektronische Aufklärung, Cyber-Telemetrie bis hin zu OSINT (Open Source Intelligence).

Die Fähigkeit, relevante Informationen rechtzeitig zusammenzuführen, zu analysieren und nutzbar zu machen, entscheidet über: – Situationsverständnis: Echtzeit-Lagebild vs. verzögerter Situationserkenntnis – Reaktionsvermögen: Proaktive vs. reaktive Cyber-Abwehr – Durchhaltefähigkeit: Optimierte Flottenverfügbarkeit durch predictive maintenance.

Entscheidungsgeschwindigkeit beeinflusst damit unmittelbar Einsatzfähigkeit, Reaktionsvermögen und Durchhaltefähigkeit – sowohl in militärischen als auch in behördlichen und industriellen Kontexten.

Warum klassische IT- und BI-Architekturen an ihre Grenzen stoßen

Trotz erheblicher Investitionen in Digitalisierung und IT-Sicherheit bleiben analytische Systeme im Tagesbetrieb vieler Organisationen hinter den Erwartungen zurück. Die Ursachen liegen selten in fehlender Technologie, sondern in impliziten Annahmen, die sich über Jahrzehnte etabliert haben.

Datenverarbeitung – Implizite Annahmen mit Nebenwirkungen

In vielen IT- und Datenarchitekturen wird Performance als gegebene Eigenschaft vorausgesetzt, nicht als explizite Anforderung definiert. Analytics wird organisatorisch und technisch häufig von Fachverfahren und operativen Systemen getrennt betrachtet. Auswertungen folgen damit einer Logik, die aus klassischen Business-Intelligence-Szenarien stammt: periodisch, aggregiert, nachgelagert.

Diese Denkweise ist nachvollziehbar – sie kollidiert jedoch zunehmend mit den Anforderungen moderner Defence-Anwendungsfälle:

- Multi-Sensor Fusion: Radar, EO/IR, Cyber und OSINT müssen in near-real-time korreliert werden

- Predictive Maintenance: Teletriedaten von Flotten (Land, Luft, See) erfordern kontinuierliche Echtzeit-Analyse

- Cyber-SOC-Analytics: Massive Volumina von Log- und Event-Daten überfordern traditionelle SIEM-Ansätze

- Simulation & Wargaming: Analyse von Milliarden Simulationsdatensätze für Szenario-Vergleich

Auswirkungen im operativen Betrieb: Das Silo-Problem

Die Folge sind Datenlandschaften, die funktional korrekt, aber analytisch träge sind:

- Daten liegen in Silos (Sensor-System A, Cyber-System B, Logistik-System C)

- Analysen erfordern komplexe, fehleranfällige Vorverarbeitung und manuelle Datenharmonisierung

- Antwortzeiten überschreiten die Zeitfenster, in denen Entscheidungen noch wirksam sind

- In der Praxis entstehen Workarounds: lokale Datenkopien, manuelle Auswertungen, parallele Analysepfade außerhalb zentraler Plattformen

Aus sicherheitsbewusster Sicht ist das problematisch: Nicht, weil Sicherheitsmechanismen fehlen, sondern weil gut gemeinte Architekturen im Alltag umgangen werden, um operative Anforderungen zu erfüllen. Internationale Studien weisen darauf hin, dass genau hier neue Risiken entstehen: durch Fragmentierung, Intransparenz und eingeschränkte Governance.

Die Architektur-Transformation: Analytics Enabler für „Decision Advantage”

Das beschriebene Spannungsfeld ist kein Widerspruch zwischen Sicherheit und Nutzbarkeit, sondern ein Architektur-Problem. Sicherheit, Governance und operative Leistungsfähigkeit werden häufig getrennt optimiert. Ohne explizite Berücksichtigung analytischer Performance entstehen Systeme, die formal sicher, aber operativ schwer nutzbar sind.

Kernleistungen der Analytics im Defence-Kontext

1. High-Performance Analytics für große, heterogene Datenmengen

Ein Beispiel: Exasol ist eine In-Memory, Massively Parallel Processing (MPP) Database: – Verarbeitet Petabyte-Datenmengen mit Mission-Critical-Zuverlässigkeit – Beantwortet komplexe analytische Abfragen in Sekunden statt Minuten oder Stunden – Ermöglicht ad-hoc-Analysen in Echtzeit – nicht nur vordefinierte Reports

Praktischer Nutzen für Defence: – Multi-Sensor Fusion: Radar-, EO/IR-, Cyber- und OSINT-Daten werden in Echtzeit korreliert für ein gemeinsames Lagebild (Common Operational Picture) – Cyber SOC Analytics: Millionen Log-Events pro Sekunde werden in near-real-time korreliert – Threat Detection in Sekunden statt Stunden – Predictive Maintenance: Teletriedaten von Flotten werden kontinuierlich analysiert, um Fehler frühzeitig zu erkennen und Ausfallzeiten zu minimieren

2. Architektur-Vereinfachung durch zentrale Analytics-Schicht

Reduzierte ETL-Pipelines, Datenmarts und Pre-Aggregationen durch eine zentrale, hochperformanten Analytics-Schicht: – Ein zentrales System statt fragmentierter Datenlandschaften – Automatische Indexierung und Selbstoptimierung – kaum Tuning-Overhead – Plug-in-Konzept für Integration mit bestehenden C4ISR/C5ISR-, SIEM- und Systemlandschaften

Praktischer Nutzen: – Reduktion von Betriebskomplexität und Fachkräfte-Anforderungen – Schnellere Time-to-Insight für neue Analysefragen – Bessere Datenhoheit: Zentrale Kontrolle statt fragmentierter Workarounds

3. Data Sovereignty & sichere On-Prem/Air-Gapped Deployment

Im Defence-Umfeld ist Datenhoheit kritisch. Analyse läuft dort, wo es sein muss: – On-Premises (Haupt-Kommandozentralen, taktische Datenzentren) – Hybrid (Kombination von klassischen Rechenzentren und Cloud) – Air-Gapped (isolierte Netzwerke ohne externe Verbindungen)

Mit umfassenden Sicherheitsmechanismen: – Role-Based Access Control (RBAC) auf Tabellen- und Row-Level – Vollständige Auditing und Verschlüsselung – Unterstützung für Defense & Government Compliance (auch NATO-Standards)

4. AI/ML-Ready Plattform mit moderner Feature-Engineering

Beschleunigte ML-Pipelines durch: – Native UDF-Container für Python, R und Lua – GPU-Support für ML-Inferenz – Feature Stores für kollaboratives Feature-Engineering bei Milliarden Datensätzen – Text-to-SQL & LLM-Integration für selbstbediente Analytik durch Nicht-Datenbankexperten

Praktischer Nutzen im Defence: – Schnellere Entwicklung von Threat-Detection-Modellen – Anomalieerkennung über Sensor- und Telemetiedaten in Echtzeit – Unterstützung für AI-gestützte Entscheidungsfindung (Decision Support Systems)

Kern-Use-Cases: Analytics im Einsatz

1. Multi-Sensor Fusion & Operational Analytics

Vorher: – Sensorsysteme arbeiten in Silos (Radar, EO/IR, Cyber, OSINT) – Langsame, manuelle Cross-Domain-Korrelation – Verzögerte Situationserkenntnis

Gefordert: – Echtzeit-Integration aller Multi-INT-Datenströme – Common Operational Picture in near-real-time – Schnellere Situationserkenntnis → bessere Entscheidungen

2. Cyber Situation Reports & SOC Analytics

Vorher: – Massive Log- und Event-Volumina überfordern SOC-Teams – Slow Correlation zwischen Network-, Endpoint- und System-Logs – Reaktive statt proaktive Incident Response

Gefordert: – Hochgeschwindigkeit-Korrelation großer Datenmengen – Schnellere Threat Detection – Proaktive Cyber-Incident-Response in sicheren Umgebungen (Air-Gapped)

3. Predictive Maintenance & Fleet Analytics

Vorher: – Ungeplante Ausfallzeiten reduzieren Verfügbarkeit – Reaktive (teure) statt Condition-Based Maintenance – Engpässe in Ersatzteil-Logistik

Gefordert: – Früherkennung von Fehlermustern in Teletriedaten – Optimierte Wartungsplanung → höhere Flottenverfügbarkeit – Reduktion von Logistik-Kosten durch intelligente Spare-Parts-Vorhersage

4. Simulation, Wargaming & Digital Twins

Vorher: – Simulationsergebnisse werden gespeichert, aber selten in Echtzeit analysiert – Szenario-Vergleiche dauern lange – Begrenzte Fähigkeit, Szenarien und Trade-Offs zu verstehen

Gefordert: – Skalierbare Analytik über Milliarden Simulationsdatensätze – Schneller Szenario-Vergleich – Tiefere Einblicke in Systemverhalten und Trade-Offs

5. C4ISR/C5ISR Analytics

Vorher: – Multi-INT-Daten verteilt über mehrere Systeme – Ineffiziente Cross-Domain-Korrelation – Analytics-Bottlenecks verlangsamen Analyse

Gefordert: – Zentrale Analytics für fused Multi-INT Daten – Schnelle Cross-Domain-Korrelation – Klare Trennung zwischen Analytics und Command-and-Control-Systemen

Vom Technologie-Hype zur operativen Realität

Die Diskussion um Digitalisierung im Defence-Umfeld verschiebt sich. Nicht mehr einzelne Technologien oder Plattformen stehen im Mittelpunkt, sondern die Frage, wie Datenverarbeitung systematisch zur operativen Leistungsfähigkeit beiträgt.

Organisationen benötigen nicht primär mehr Daten oder komplexere Systeme. Entscheidend ist eine bewusste architektonische Entscheidung darüber, wie analytische Leistungsfähigkeit künftig integriert wird:

Exasol liefert dafür: 1. Ultra-hohe Performance für schnelle Entscheidungen unter Druck 2. Architektur-Vereinfachung statt Tool-Sprawl 3. Data Sovereignty & Kontrolle für sensitive Defence-Daten 4. AI/ML-Readiness für die nächste Generation von Decision Support 5. Europäische Technologie & Vertrauenswürdigkeit

Datenverarbeitung entwickelt sich damit von einer unterstützenden IT-Funktion zu einer eigenständigen operativen Fähigkeit – vergleichbar mit Sensorik, Kommunikation oder Führungssystemen. Exasol möchte hierfür ein lokaler kompetenter Partner sein.

Text: Autorenteam Exasol

Mit WhatsApp immer auf dem neuesten Stand bleiben!

Abonnieren Sie unseren WhatsApp-Kanal, um die Neuigkeiten direkt auf Ihr Handy zu erhalten. Einfach den QR-Code auf Ihrem Smartphone einscannen oder – sollten Sie hier bereits mit Ihrem Mobile lesen – diesem Link folgen: